10 ужасных технологий, которые не должны существовать

Научно-технический прогресс принёс человечеству огромную пользу, но он же может стать причиной нашего уничтожения

Чем дальше мы двигаемся в 21-й век, тем чаще мы начинаем представлять себе фантастические возможности, которые ждут нас. Вместе с тем нас преследует и мрачное предчувствие ужасов, ждущих в будущем. Ниже перечислены 10 страшных технологий, не имеющих права на существование.

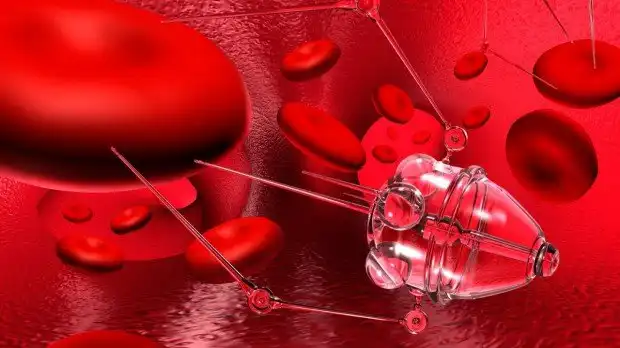

1. Военные нанотехнологии

Ничто не сможет закончить наше царствование на Земле быстрее, чем военные (или просто чрезвычайно неудачно реализованные) нанотехнологии. Это угроза, которая исходит от двух невероятно мощных сил: от бесконтрольного самовоспроизведения и экспоненциального роста. Достаточно нигилистичное правительство, негосударственная организация, или отдельная личность могут создать микроскопические машины, которые в ходе самовоспроизведения уничтожат все важнейшие ресурсы нашей планеты со скоростью лесного пожара, и оставят после себя только совершенно бесполезные би-продукты, остатки, которые футурологи очень любят называть «серой слизью».

Теоретик нанотехнологий Роберт Фрейтас предпринял «мозговой штурм», и выдал несколько вариантов того, как нанотехнологии могут уничтожить планету. В числе этих вариантов была так называемая «серая пыль», «серый планктон», «серые лишайники» и «убийцы биомассы». «Серая пыль» способна затмить солнечный свет, «серый планктон» может оказаться на дне моря и уничтожить всю морскую экосистему, «серые лишайники» уничтожат полезные ресурсы на поверхности, а «убийцы биомассы» истребят все живые организмы. По словам Фрейтаса, наихудший сценарий такой «глобальной экофагии» займёт около 20 месяцев, которых будет более чем достаточно для выработки эффективной защиты. Под «защитой» Фрейтас подразумевает разработку других самореплицирующихся нанороботов, способных разрушать внутренние системы «захватчиков». Другой мерой может быть создание так называемых «активных щитов», хотя большинство экспертов по нанотехнологиям в один голос говорят о том, что такие «щиты» окажутся бесполезны. А значит, на военные нанотехнологии должен быть установлен мораторий, и он должен неукоснительно соблюдаться.

2. Сознательные машины

Однажды мы вдохнём в машину искусственное сознание. Но мы должны серьёзно подумать, прежде чем сделать это. На самом деле это может быть очень жестоко — построить полнофункциональный мозг внутри компьютера. И это относится как к человеку, так и к его «копии». Ещё в 2003-м году философ Томас Метцингер утверждал, что это было бы чудовищно неэтично:

«Что бы вы сказали, если бы кто-то пришёл к вам, и заявил: „Эй, мы хотим генетически модифицировать умственно отсталых человеческих младенцев! Для научного прогресса нам необходимы дети с определённым познавательным и эмоциональным дефицитом для того, чтобы мы могли изучить их послеродовое психологическое развитие, и нам срочно необходимо предоставить финансирование для этого важного и инновационного вида исследований“. Вы наверняка решили бы, что это не только абсурдная, но и опасная идея. Надеемся, ни один комитет по этике этого никогда не одобрит. Однако кое-чего сегодняшние комитеты по этике не видят. Они не видят появления первых машин, у которых уже есть минимальный набор связей, которых достаточно для получения начального сознательного опыта, такого же, как у умственно отсталого ребёнка. А значит, такие машины будут страдать от всех видов функционального и репрезентативного дефицита. Вдобавок, они не будут иметь никакого политического лобби — никаких представителей ни в одном комитете по этике».

Футуролог Луи Хельм согласен с этим. Вот что он говорит:

«Одной из лучших вещей в компьютерах является то, что вы можете заставить их производить миллионы операций в секунду не заботясь о том, что они могут обидеться, или что им станет скучно. Так как мы планируем использовать труд искусственного интеллекта вместо интеллектуального труда человека, я думаю, было бы аморально запрограммировать его так, чтобы он стал сознательным. Заключить сознательное существо в машину, и заставить его работать за вас — это просто возвращение к рабству».

3. Искусственный интеллект

Как заявил в этом году Стивен Хокинг, искусственный интеллект может быть нашей худшей ошибкой за всю историю. Это не раз отмечалось и другими учёными. Появление интеллекта, превосходящего человеческий, может оказаться катастрофическим. Внедрение в нашу жизнь систем, которые гораздо быстрее и умнее нас, отодвинет нас на второй план. Мы будем отданы на милость искусственного разума, который станет решать всё за нас. К тому же далеко не факт, что мы сможем создать дружественный искусственный интеллект. Мы должны решить эту проблему, в противном случае создание искусственного интеллекта будет безумием чистой воды.

4. Путешествия во времени

На свете не так много людей, верящих в путешествия во времени. Но если нечто подобное всё-таки возможно, то нам лучше держаться от этого подальше, поскольку это было бы безумно опасно. Любой научно-фантастический фильм, связанный с изменением временных линий, должен дать вам представление о потенциальных опасностях этой технологии, и особенно об этих отвратительных временных парадоксах. И даже если некоторые формы квантовых путешествий во времени всё-таки возможны (в ходе чего будут создаваться отдельные, совершенно новые временные линии), то культурный и технологический обмен между слишком разными по своему развитию цивилизациями просто не может закончиться хорошо.

5. Устройства для чтения мыслей

В перспективе могут быть созданы машины, с помощью которых можно будет прочесть мысли и воспоминания людей, причём на расстоянии и без их согласия. Но очевидно, что это не станет возможным до тех пор, пока человеческий мозг не будет более тесно интегрирован в веб, и в другие системы связи. В прошлом году, к примеру, учёные из Нидерландов использовали данные, полученные в результате сканирования мозга, и некоторые компьютерные алгоритмы для того чтобы определить, на какие буквы смотрит человек. Этот научный прорыв наверняка намекнул третьим лицам на то, что реконструкция человеческих мыслей вскоре может выйти на беспрецедентно высокий уровень детализации. Можно будет узнать, что мы видим, помним, и о чём думаем. Такие устройства, если использовать их массово, могут быть хорошим подспорьем тоталитарному режиму или какому-нибудь полицейскому государству, и сделают жизнь просто невыносимой. И это будет мир Оруэлла, в котором людей наказывают за «мыслепреступления».

6. Устройства для «взлома» мозга

Наш разум тоже может быть изменён без нашего ведома и без нашего согласия. Однажды в наших мозгах появятся чипы, и если предположить, что мы не сможем разработать эффективные «мозговые брандмауэры», то наши умы будут доступны из любого сегмента Интернета. Невероятно, но мы уже сделали первые шаги в этом направлении. Недавно международная группа нейробиологов провела эксперимент, который позволил участникам осуществить «слияние разумов» посредством Интернета. С одной стороны это здорово. Но с другой стороны такая «техническая телепатия» может стать настоящим ящиком Пандоры. Возможно, самая лучшая (и самая страшная) иллюстрация этой угрозы была представлена в аниме «Призрак в доспехах». В этом фильме искусственный интеллект «взламывал» мозги людей, и был способен модифицировать их воспоминания и намерения. А теперь представьте такую технологию в руках организованной преступности или параноидального правительства.

7. Автономные роботы, разработанные, чтобы убивать людей

Опасность автономных машин для убийства это страшный, и пожалуй, единственный пункт в этом списке, который актуален уже сегодня. Вот что по этому поводу говорит футуролог Майкл ЛаТорра:

«У нас пока ещё нет машин, демонстрирующих интеллект, который хотя бы немного напоминал человеческий. Но смертоносным автономным роботам человеческий интеллект и не нужен. Роботизированные боевые машины всех видов успешно строят уже сейчас. Роботы-танки, роботы-самолёты, роботы-подводные лодки, и даже роботы-солдаты создаются уже сегодня. В отличие от дистанционно управляемых самолётов-беспилотников, военные роботы могут самостоятельно определять цели и уничтожать их без участия человека, самостоятельно принимая решение открыть огонь. Опасность подобной технологии очевидна, и она выходит за рамки угрозы инцидентов „дружественного огня“, в ходе которых робот может убить солдат, находящихся с ним на одной стороне, или даже невинных гражданских. Огромная опасность таится в гонке международных вооружений, так как она может побудить какую-то из наций начать строительство автономных боевых роботов. Через несколько циклов усовершенствования появятся роботы нового поколения, которые смогут победить любую систему, контролируемую человеком. А потом либо случайно („Кто же знал, что искусственный интеллект может спонтанно возникнуть в военном роботе“?), либо по злому умыслу („Мы как-то не подумали о том, что хакеры могут перепрограммировать наших военных роботов на расстоянии“!), человечество может оказаться в полном подчинении у своих новых повелителей».

8. Военные патогены

Ещё одна плохая, но пугающе актуальная вещь. Ещё в 2005-м году Рей Курцвейл и Билл Джой опубликовали геномы смертельных вирусов для всего мира, так что все смогли увидеть эти рецепты нашего уничтожения. Всегда существует возможность того, что отдельно взятый идиот или группа фанатиков воспользуются этой информацией, и воссоздадут смертельный вирус с нуля, либо внесут изменения в какой-нибудь существующий вирус, чтобы сделать его смертельным, а затем выпустить в окружающую среду. Считалось, например, что пресловутый «птичий грипп» мог убить половину людей на земном шаре. А кое-кто считал, что этот вирус был создан искусственно. Конечно, главное в таких ситуациях — знать врага в лицо, и разработать возможные контрмеры до того, как разразится пандемия. Но всегда есть опасность того, что вирус может выйти за пределы лаборатории, и начнёт убивать население.

9. Виртуальные тюрьмы и наказания

Чем станут тюрьмы и наказания, если люди когда-нибудь смогут жить в течение сотен, или даже тысяч лет? И что если умы заключённых будут загружаться в «виртуальные тюрьмы»? Специалист по этике Ребекка Роуч делится страшными сценариями:

«Преимущества от радикального увеличения продолжительности жизни очевидны, но они также могут быть использованы и для повышения суровости наказаний. В случае, когда тридцатилетнее заключение покажется судье слишком мягким приговором, осужденный преступник может быть приговорён к пожизненному заключению, которое сочетается с принудительным продолжением жизни. В результате пожизненное лишение свободы может означать срок в несколько сотен лет, а не десятилетий. Обществу, конечно, дорого обойдётся поддержка таких приговоров. Но если повышение продолжительности жизни будет доступно всем, эти затраты могут быть компенсированы повышением производительных сил.

Существует и другой вариант. Ум осуждённого преступника загружается в компьютер, и скорость работы этого разума принудительно увеличивается в миллион раз, так что 1000 лет лишения свободы легко умещаются в 8,5 часов. Такой подход, очевидно, обойдётся налогоплательщикам куда дешевле, чем принудительное увеличение продолжительности жизни преступника».

Это ужасно. Тут важно отметить, что Роуч не выступает за такие методы наказания, она всего лишь сделала некоторые предположения. Но будет лучше, если они никогда не станут реальностью.

10. Адская инженерная деятельность

Этот пункт немного похож на предыдущий. Некоторые футурологи делают прогнозы для «райской инженерной деятельности», под которой подразумевается использование передовых технологий, в частности, загрузку сознания в виртуальную реальность для того, чтобы создать рай на Земле. Но коль скоро вы можете создать рай, значит, можете создать и ад. И эта перспектив особенно пугает, если предположить, что в будущем жизнь человека может быть очень долгой, и в этой жизни будет множество возможностей для причинения физических и психологических страданий. На самом деле это одна из худших вещей, которые могут случиться. Плюс появляется ещё одна причина для запрета на разработку искусственного интеллекта: возникновение «проблемы Василиска Роко» («Василиск Роко» — богоподобная и чрезвычайно опасная форма искусственного интеллекта).