Пока можно спать спокойно: искусственный интеллект без людей поглотит сам себя. Исследование учёных из США

В последние месяцы все больше разговоров ходит о том, что скоро искусственный интеллект оставит без работы людей многих творческих и гуманитарных профессий. Однако ученые из США пришли к иному мнению.

Исследователи из Университета Райса и Стэнфордского университета повели исследование, которое показало, что искусственный интеллект не может обойтись без человека. Дело в том, что алгоритмы ИИ обычно обучаются на основе существующих наборов данных, которые уже созданы людьми.

Например, генеративные модели, которые создают красивые изображения (типа Midjourney или Stable Diffusion) обучают на миллионах картинок и фотографий, сделанных фотографами и художниками. А если люди перестанут создавать такой контент, то в будущем алгоритмам придется обучать нейронки на контенте, который был сгенерирован ими же самими или другими алгоритмами. И это может привести к серьезным проблемам.

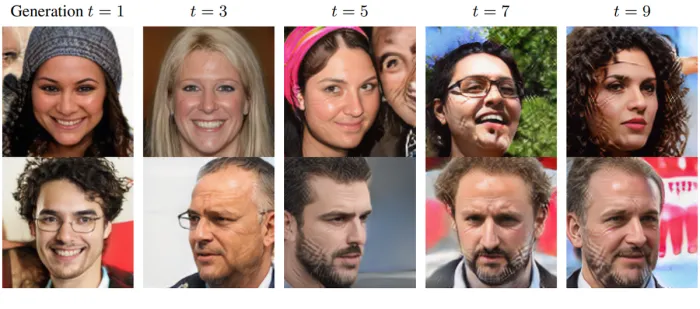

Исследователи провели эксперимент с генеративными моделями изображений, которые способны создавать реалистичные фотографии людей, животных, пейзажей. Они обучили модели на реальных фото, а затем на изображениях, которые были сгенерированы после первоначального обучения. Этот процесс повторили несколько раз и наблюдали за тем, как меняется качество и разнообразие изображений на выходе.

Оказалось, что после каждого цикла обучения на искусственном контенте модели начинали проявлять признаки деградации. Изображения становились менее четкими, менее реалистичными и менее разнообразными. А некоторые результаты на выходе становились и вовсе бессмысленными. Это можно сравнить со студийной фотографией, с которой сделали копию, потом сняли копию с копии и так далее. В итоге конечный результат начинает выглядеть так, будто фото было сделано на тапок, а не с помощью профессиональной фототехники.

Авторы исследования назвали этот эффект Model Autophagy Disorder (самопоглощение модели), или MAD. Аббревиатура тоже подходящая - слово «mad» переводится с английского языка как «обезумевший». Т. е. модель, обученная на искусственно созданном контенте, начинает поглощать сама себя.

Вывод исследователей состоит в том, что искусственный интеллект пока недостаточно хорош, чтобы быть самодостаточным, и для обучения ему требуется ввод данных, созданных человеком. К сожалению, здесь ключевое слово «пока».

Например, генеративные модели, которые создают красивые изображения (типа Midjourney или Stable Diffusion) обучают на миллионах картинок и фотографий, сделанных фотографами и художниками. А если люди перестанут создавать такой контент, то в будущем алгоритмам придется обучать нейронки на контенте, который был сгенерирован ими же самими или другими алгоритмами. И это может привести к серьезным проблемам.

Исследователи провели эксперимент с генеративными моделями изображений, которые способны создавать реалистичные фотографии людей, животных, пейзажей. Они обучили модели на реальных фото, а затем на изображениях, которые были сгенерированы после первоначального обучения. Этот процесс повторили несколько раз и наблюдали за тем, как меняется качество и разнообразие изображений на выходе.

Полученные изображения после различного количества циклов обучения на сгенерированном контенте

Оказалось, что после каждого цикла обучения на искусственном контенте модели начинали проявлять признаки деградации. Изображения становились менее четкими, менее реалистичными и менее разнообразными. А некоторые результаты на выходе становились и вовсе бессмысленными. Это можно сравнить со студийной фотографией, с которой сделали копию, потом сняли копию с копии и так далее. В итоге конечный результат начинает выглядеть так, будто фото было сделано на тапок, а не с помощью профессиональной фототехники.

Авторы исследования назвали этот эффект Model Autophagy Disorder (самопоглощение модели), или MAD. Аббревиатура тоже подходящая - слово «mad» переводится с английского языка как «обезумевший». Т. е. модель, обученная на искусственно созданном контенте, начинает поглощать сама себя.

Вывод исследователей состоит в том, что искусственный интеллект пока недостаточно хорош, чтобы быть самодостаточным, и для обучения ему требуется ввод данных, созданных человеком. К сожалению, здесь ключевое слово «пока».

Комментарии1